Введение

В этом репозитории представлен результат обучения LoRA в рамках курса по LLM от VK.

В наших экспериментах используется датасет cardiffnlp/tweet_eval. Решаемая задача - предсказание тональности текста (Sentiment Classification). Для файнтюна на задачу Sentiment Classification бралась модель OuteAI/Lite-Oute-1-300M-Instruct. Эта модель имеет около 300 млн обучаемых параметров, размер контекста модели до 4096 токенов.

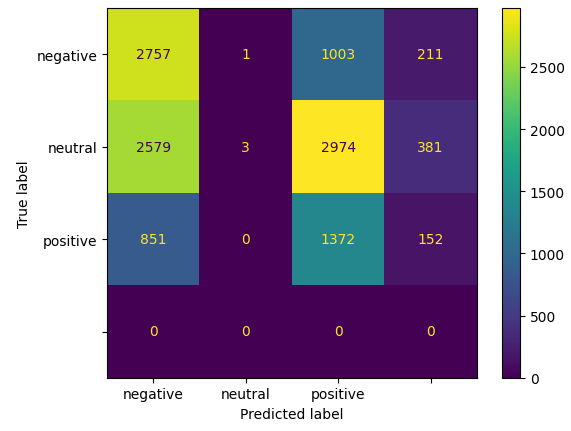

Отметим, что в zero-shot режиме качество предсказаний модели даже с учётом вспомогательных сценариев (некоторого парсинга ответов модели) остаётся довольно низким.

Детали

Описание модели

LoRA - один из способов эффективного файнтюна модели. Идея, описанная в статье довольно проста: мы можем выучить скелетные разложения матриц вместо полных матриц, что сильно сокращает число используемых параметров.

Отметим, что это в каком-то смысле делает модель менее экспрессивной, если для дообучения имеется обчень большой датасет. Однако в большинстве случаев это не так, и такой аппроксимации низкоранговыми матрицами вполне достаточно.

Сравнение результатов моделей

Baseline (F1 = 0.22)

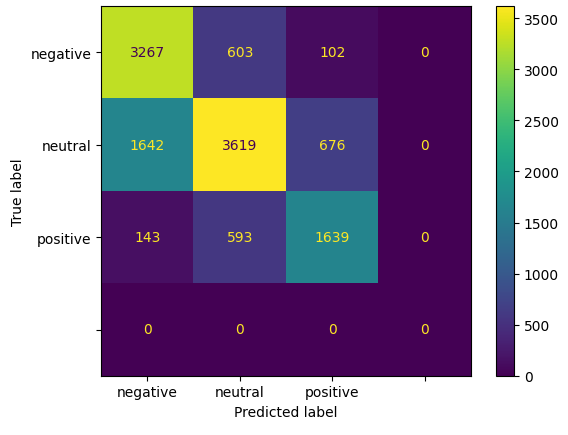

LoRA (F1 = 0.52)

DoRA (F1 = 0.50)

Референсы

- Модель: OuteAI/Lite-Oute-1-300M-Instruct

- Датасет: cardiffnlp/tweet_eval

- Оригинальная статья: https://arxiv.org/abs/2106.09685

- Downloads last month

- 5